A cura dell'Avv. Paolo La Manna

Nel dicembre 2023 il Parlamento

europeo e il Consiglio dell’UE hanno raggiunto un accordo politico sulla legge

sull'Intelligenza Artificiale ed il 13 marzo 2024 è stato approvato dal

Parlamento europeo l’AI Act.

L’obiettivo dichiarato è quello

di proteggere i diritti fondamentali, la democrazia, lo Stato

di diritto e la sostenibilità ambientale dai sistemi di IA ad alto

rischio, promuovendo nel contempo l’innovazione e assicurando

all’Europa un ruolo guida nel settore. Il regolamento stabilisce obblighi

per l’IA sulla base dei possibili rischi e del livello

d'impatto.

“L'IA dovrebbe rappresentare

uno strumento per le persone e un fattore positivo per la società, con il fine

ultimo di migliorare il benessere degli esseri umani“ (Relazione

accompagnatoria alla proposta di adozione dell’AI ACT). L’IA viene individuata

quale una tecnologia antropocentrica che si inserisce in un più ampio pacchetto

di misure politiche a sostegno di una IA affidabile, con l’obiettivo di garantire

la sicurezza e i diritti fondamentali delle persone e delle imprese e

rafforzare la diffusione, gli investimenti e l’innovazione in tutta l’Unione

Europea.

A tal fine, la Commissione ha

deciso di istituire, con decisione del 24 gennaio 2024, l’Ufficio Europeo per

l’IA previsto dall’art. 64 dell’AI Act, che ha il compito di contribuire

all’attuazione, al monitoraggio e alla supervisione dei sistemi e della governance dell’IA.

L’Ufficio, che sarà affiancato da

un gruppo scientifico di esperti indipendenti, infatti, ha il compito di

collaborare con gli organi di governance degli Stati membri

nello svolgimento dei loro compiti e con la più ampia comunità di esperti

combinando le conoscenze nei diversi campi e settori (comunità scientifica,

società civile, industria) valutando sviluppi possibili, potenziali vantaggi e rischi.

Dovrebbe diventare un organismo centrale di coordinamento per la politica in

materia di IA a livello UE e cooperare con gli altri dipartimenti della

Commissione, gli organismi dell’UE, gli Stati membri e la comunità delle parti

interessate. Sarà affiancato da un Gruppo scientifico di esperti indipendenti.

Il regolamento deve ancora essere

sottoposto alla verifica finale dei giuristi-linguisti e dovrebbe essere

adottato definitivamente prima della fine della legislatura (procedura di

rettifica). Inoltre, la legge deve ancora essere formalmente approvata dal

Consiglio.

Entrerà in vigore (180

Considerando, 113 Articoli, 13 Allegati) 20 giorni dopo la pubblicazione nella

Gazzetta ufficiale UE e inizierà ad applicarsi 24 mesi dopo l'entrata in

vigore. Tuttavia, prevede, in alcune aree di regolamentazione, una applicazione

graduale ed anticipata. Difatti:

§ i

divieti relativi a pratiche vietate si applicheranno a partire da sei mesi dopo

l’entrata in vigore;

§ i

codici di buone pratiche si applicheranno nove mesi dopo l'entrata in vigore;

§ le norme sui sistemi di IA per finalità generali, compresa la governance, si applicheranno dodici mesi dopo l'entrata in vigore;

§ gli obblighi per i sistemi ad alto rischio si applicheranno trentasei mesi dopo l'entrata in vigore.

L’intelligenza artificiale può

trasformare profondamente la società e l’economia, con benefici potenziali per

la società e l’economia. Allo stesso tempo, l’IA può anche presentare dei

rischi per i diritti, la sicurezza e il buon funzionamento del mercato unico.

Per trovare un equilibrio tra le due istanze – accompagnare l’Europa

nell’adozione dell’IA e dei suoi benefici e farlo per l’interesse generale – l’AI

Act è stato pensato con un approccio basato sul rischio.

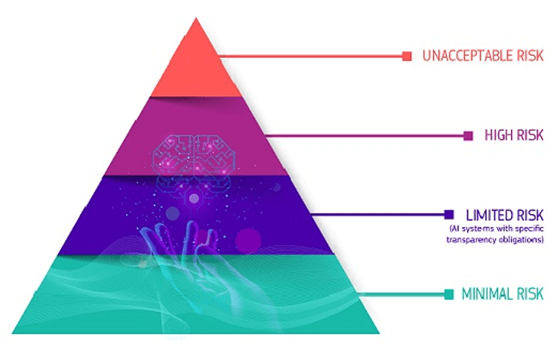

Il primo passo per le imprese, dunque, sarà quello di classificare i loro sistemi di IA in base al livello specifico di rischio. L’AI Act distingue quattro categorie principali: rischio inaccettabile, alto rischio, rischio limitato e rischio minimo. Ogni categoria ha requisiti specifici. Ad esempio, i sistemi di IA a rischio inaccettabile, come quelli che utilizzano tecniche di manipolazione subliminale o di punteggio sociale (social scoring), sono vietati.

Il Regolamento, in virtù delle previsioni contenute, sarà caratterizzato da una applicazione estremamente diffusa.

Difatti, l’articolo 2 definisce l’ambito

di applicazione del regolamento, identificando con ciò anche i diversi

soggetti interessati all’adeguamento ai principi espressi.

Le nuove regole – tese a governare

l’immissione sul mercato, la messa in servizio e l’uso dei sistemi di IA

nell’UE (articolo 1) – si applicheranno innanzitutto ai «fornitori» dei

sistemi di intelligenza artificiale (sia pubblici che privati) che

immettono sul mercato o mettono in servizio sistemi di IA nell’UE,

indipendentemente da dove i fornitori stessi siano stabiliti, e a quelli

situati in un paese terzo, laddove l’output prodotto dal sistema di IA sia

utilizzato in Europa.

Dovranno inoltre rispettare le

norme dell’AI Act gli «operatori» che hanno sede o sono situati nell’UE

e quelli situati in un paese terzo, sempre ove l’output prodotto dal sistema di

intelligenza artificiale venga utilizzato in Europa.

È questa una previsione analoga

rispetto a quella del GDPR, che ha prodotto quell’effetto di applicazione

globale del Regolamento sulla circolazione e protezione dei dati che ben

conosciamo.

Il legislatore europeo intende cosi

duplicare il successo del GDPR e porre al centro dei mercati mondiali le

proprie innovative e sfidanti regole sull’AI. Il regolamento si applicherà

altresì agli altri componenti della catena di valore dell’IA, quali importatori,

distributori, fabbricanti e rappresentanti autorizzati.

Le Organizzazioni, dunque, saranno

chiamate nei prossimi due anni ad adeguarsi alla nuova normativa, richiedendo

il contributo di molteplici figure aziendali a cui sarà richiesto, oltre ad uno

studio accurato del Regolamento, anche la conduzione di una gap

analysis al fine di adottare le misure idonee per conformarsi all’AI

Act.

Tra le attività di compliance che

occorrerà intraprendere, vi sono:

§ l’esecuzione

di una valutazione del rischio,

verificando, ad esempio, che non siano adottati sistemi di IA a rischio

inaccettabile, come quelli che utilizzano tecniche di manipolazione subliminale

o di social scoring;

§ la

stima della probabilità e dell’impatto dei rischi accettabili individuati, considerando aspetti come la

sicurezza, l’affidabilità e l’impatto sui diritti fondamentali degli utenti;

§ l’assegnazione

della classificazione di rischio appropriata al

sistema utilizzato, fornendo anche informazioni chiare e trasparenti agli

utenti;

§ l’implementazione

delle idonee misure di mitigazione del rischio, tramite misure di sorveglianza continua per

monitorare le prestazioni del sistema e garantire che rimanga sicuro e conforme

alle normative, ivi inclusa la raccolta e l’analisi di dati post-mercato per

identificare e risolvere eventuali problemi che potrebbero emergere, nonché la

protezione dei dati personali e della privacy.

Le attività di compliance,

naturalmente, dovranno essere documentate e rendicontate, in osservanza dei

principi di accountability e trasparenza.

Per i sistemi di IA ad alto

rischio, la conformità dovrà essere verificata attraverso procedure di

valutazione e certificazione. Questo processo può includere test, audit e

verifiche da parte di organismi indipendenti. Ottenere una certificazione può

essere complesso, ma è essenziale per dimostrare che i sistemi adottati

rispettino tutte le norme di sicurezza e qualità richieste.

Adeguarsi all’AI Act rappresenta

una sfida, ma anche un’opportunità. Le imprese dovranno formare il personale,

aggiornare i sistemi esistenti e collaborare con giuristi e tecnici, attraverso

un dipartimento interno per la gestione della compliance o

professionisti esterni, per affrontare in modo profittevole – ma socialmente

responsabile - le nuove sfide tecnologiche.